TECNOLOGÍA Y CIENCIA |

|

|

En los primeros instantes de la informática, las computadoras de las décadas de los años 70 y 80 se presentaban a sí mismas como sistemas abiertos, es decir, ofreciendo a los usuarios la “ilusión” de suponer que podían comprender su mecanismo interno de funcionamiento, algo que en cierta manera por una vez y gracias a su simplicidad algunos si podían alcanzar en un alto grado.

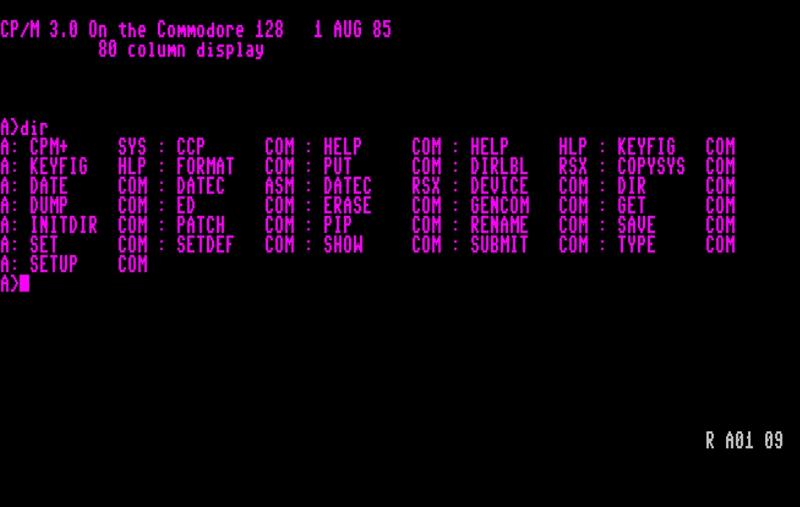

Eran aquellos tiempos de los comandos CP/M, DOS o el BASIC con los cuales, a través de una sintaxis muy específica, se interactuaba con el ordenador, que podía realizar distintas tareas muy concretas para el usuario.

En aquella era incipiente, la cultura informática giraba en torno a comprender las mecánicas internas del ordenador a través de una simplicidad aparente, como suponía el conocimiento de las instrucciones básicas con las que interactuábamos y que nos proporcionaban un placer y satisfacción basado en la premisa de poder “controlar la máquina”.

Así que, podemos decir que era una interpretación modernista de la comprensión, según la cual, ésta misma, procedía de la reducción de elementos complejos, como serían los ordenadores, a elementos más sencillos, como serian las instrucciones y comandos que introducíamos a través del teclado.

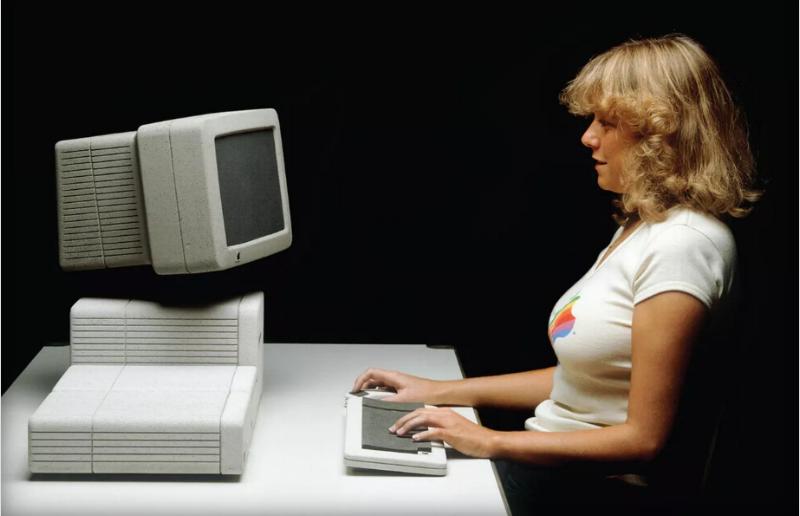

En los tiempos lejanos de los que hablamos, el máximo representante de los anhelos de cualquier joven amante de la electrónica y la ciencia informática era el preciado logo de IBM, cúspide simbólica de la tecnología de la época. Podíamos ver aquella fase a través de una metáfora muy citada donde el ordenador era como un vehículo que podías controlar. Ahora bien, era una mecánica de conducción muy básica y limitada, como conducir un tractor, pero lo que ocurrió poco después, es que apareció una forma distinta de conducción y vehículos más gráciles y sofisticados, no tanto por su hardware si no por su “diseño”.

El equipo original de Macintosh, incluyendo a Joanna Hoffman (segunda desde la izquierda) y Andy Hertzfeld (al centro, de pie).

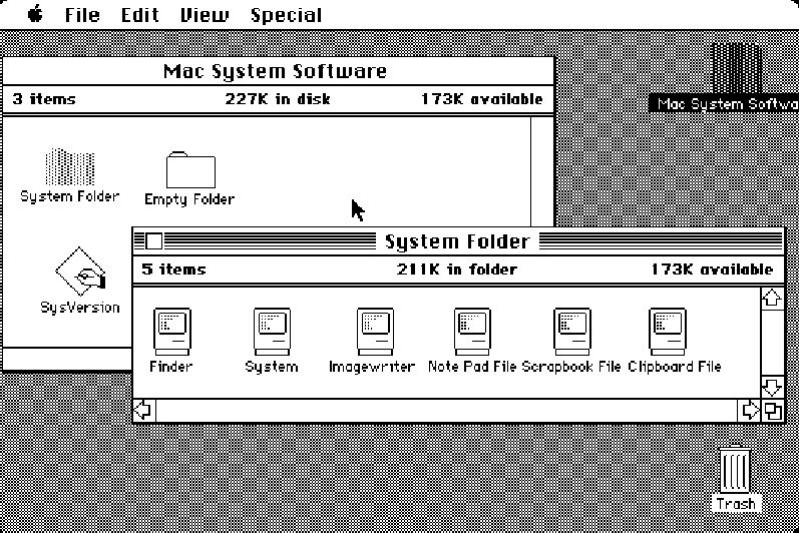

Así llegamos a mediados de los años ochenta, donde aparece el estilo icónico por antonomasia de la informática: la computadora Apple Macintosh, que simulaba de una manera básica, pero increíblemente diferente a todo lo preexistente, el espacio de un escritorio “real” y establecía por tanto un vínculo comunicativo basado en el diálogo “humano / escritorio / máquina”. En aquel momento, ya con este tipo de interfaces que podíamos llamar “opacas u invisibles”, el usuario, que no ya “programador” podía manejar el ordenador sin comprender sus mecanismos internos.El equipo original de Macintosh, incluyendo a la verdadera Joanna Hoffman (segunda desde la izquierda) y Andy Hertzfeld (al centro, de pie).

Escritorio del Apple Macintosh

Así que de pronto los usuarios se encontraron “haciendo tareas con el ordenador” más allá de “programar” y dialogar con su lenguaje interno. Esta era, por supuesto, abría una nueva sub-cultura en la que se estimulaba a los usuarios a permanecer en un nivel superficial de la potencia computacional y sintaxis de la máquina, limitándose a trabajar por medio de una representación visual, apoyados por las atractivas interpretaciones gráficas de la realidad, disponíamos de bellos iconos gráficos para representar el escritorio, una carpeta, un lápiz, papelera o un cuaderno y podíamos mover los documentos de un lado a otro, con las interacciones del ratón que simulaban nuestras manos. De este modo se consiguió crear una coherencia, es decir una nueva forma de ver e interpretar la informática, una cultura posmoderna en la cual conocer a fondo las mecánicas de la máquina perdía el interés, era mucho más interesante y fácil introducirse en ese nuevo mundo “simulado” o virtual que, intentar averiguar todos los mecanismos que gobernaban la máquina en su interior.

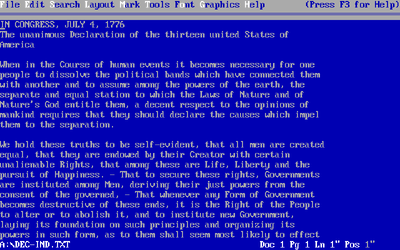

CP/M 3.0 para el ordenador Commodore 128

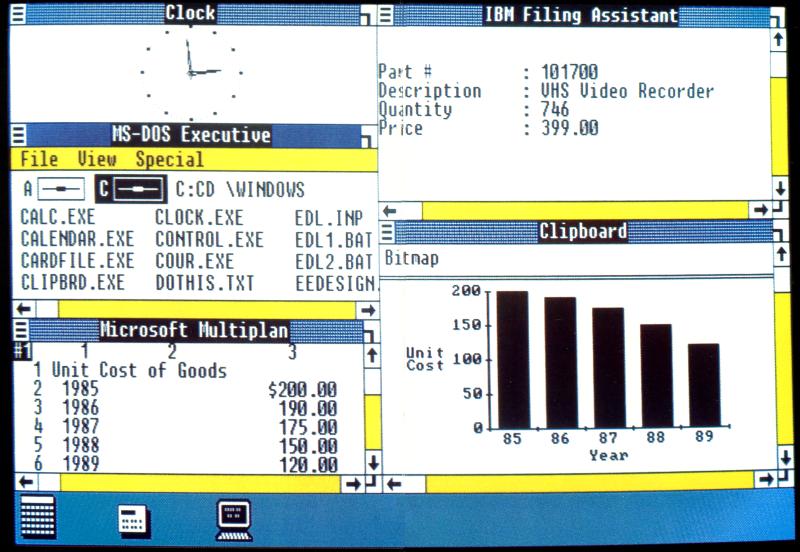

Esta nueva concepción llevó a finales de la década de los años 80 a que el conocimiento de la informática generara dos culturas bien divididas dentro de la informática personal, donde por un lado encontraríamos la cultura tecnológica del gigante IBM y en contraposición las nuevas ideas artísticas y creativas que representaban el mundo del Apple Macintosh. Estas dos visiones contrapuestas de entender la informática, iban a competir durante un tiempo por la hegemonía de la era de la computación personal. IBM ofrecía una herramienta similar a un vehículo industrial, una máquina que obedecería a través de nuestras instrucciones básicas, en contraste del Apple Macintosh, una maquina a la que podríamos fácilmente hacer entender que necesitábamos. La guerra fue hasta cierto punto cruenta y ambos sistemas intentaron transmitir sus ventajas. En aquel momento una cosa estaba clara, el dominio del MS/DOS, del CP/M o de cualquier otro sistema basado en línea de comandos que hacía necesario una serie de conocimientos, como los diferentes comandos y entender su sintaxis, los cuales se teclearían de “memoria” en nuestro teclado, tras una memorización previa, dominaba en la predilección de la mayor parte de los usuarios, sobre todo en los procedentes de una especialidad o disciplina técnica. Claro, este esfuerzo de memorización y entendimiento de los mecanismos de la máquina se traducían en un control total de esta, por aquella época los informáticos estaban a favor de este sistema pero, era un sistema al cual, la gran parte de la sociedad no podría acceder sin una instrucción y formación previa en un mundo donde la información al respecto todavía escaseaba. Así que el mundo de la informática estaba separado, por un lado primaba el control de la máquina y por el otro acercar la máquina al mayor número de usuarios, basándose en una simulación de la realidad que no necesitará unos conocimientos previos.

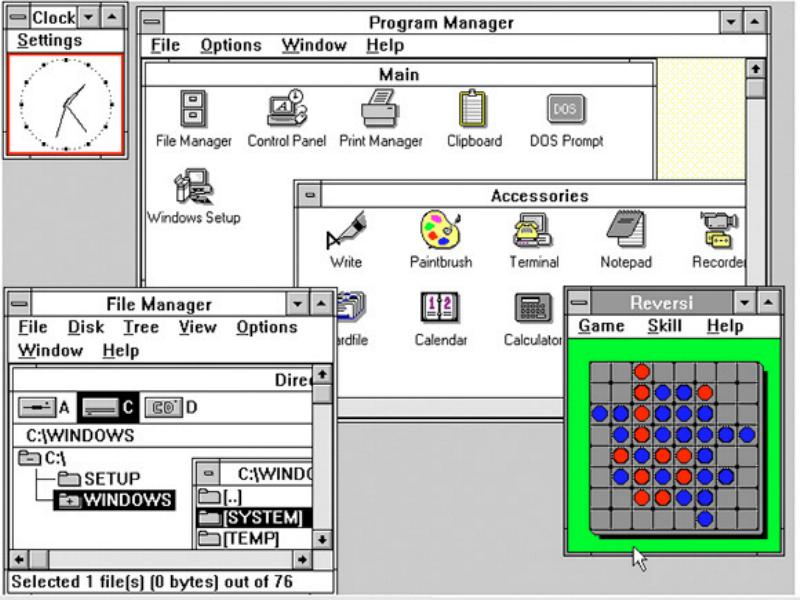

Windows 1.0 lanzado en 1985

Pero no fue hasta el año 1985, cuando se lanzó Microsoft Windows las dos estéticas de la era de la informática personal convergieron, por un lado la “técnica” y por otro la “artística”, juntas en un solo sistema operativo rudimentario e inspirado en el modelo de Apple que a su vez plagiaba la tecnología experimental de Xerox . En aquel momento el sistema operativo de Microsoft fue la solución a la batalla inicialmente establecida, la cual en su momento se interpretó como si fuese un empate, aunque analizado con el paso de los años, las tendencias que se siguieron durante la última década del siglo XX y viendo la dirección que llevamos en el principio del siglo XXI, nadie puede tener ya dudas del modelo ganador, máxime cuando Windows no dejaba de ser una copia más o menos burda de otro interfaz gráfico pero con más posibilidades a la hora de tomar el “control” de la máquina. En el momento actual, desde un punto de vista social, los sistemas basados en la “simulación” y la “virtualidad” ganaron la batalla acercando la informática a todo el mundo sin necesidad de unos conocimientos previos exhaustivos.

Windows 3.0

Toda esta simulación consiguió que pudiéramos escribir en la pantalla como haríamos en una libreta, pudiendo leer igual que como haríamos con un libro de papel, hoy en día podemos ver películas como si estuviéramos delante de nuestro televisor, dibujar, incluso jugar como haríamos antes de que existieran los ordenadores… o algo parecido, contactando y socializando con personas de todo el planeta, o casi. Y no podemos olvidar como aquellas recreaciones de la realidad atrapaban a los usuarios en un mundo nuevo, más práctico y fácil de comprender que el anterior, diseñado aparentemente para adecuarse a las necesidades de los distintos usuarios.

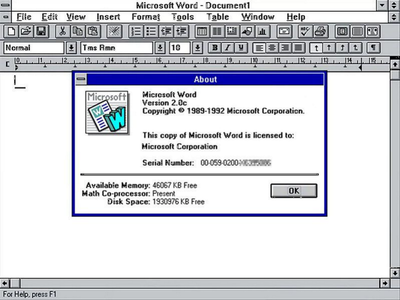

Wordperfect 5.1 a la izquierda y Microsoft Word 2.0 a la derecha

El ejemplo más básico sería como el usuario de finales deI siglo XX interactuaba con su nuevo procesador de textos, de un modo diferente hasta ese momento, sin necesidad de recordar ningún comando, solo tenía que navegar por las diferentes ventanas desplegables, viendo el abanico de posibilidades que estas le ofrecían, un abanico que no solamente le ofrecería nuevas opciones a la hora de procesar un texto sino que permitiría acceder de manera automática a distintos textos o notas en múltiples ventanas, además no podemos olvidar las nuevas opciones que las mejoras en potencia y almacenamiento daban a estos nuevos procesadores de textos a la hora de corregir el texto y un largo etcétera de opciones visuales complementarias. En aquel momento, con el aumento constante de la potencia computacional y la reducción de los precios, las posibilidades parecían infinitas en los nuevos ordenadores personales pero, aún quedaba algo más grande para tambalear los pilares de nuestra sociedad, los ordenadores y las nuevas tecnologías habían incubado algo más, habían propiciado el nacimiento de Internet, donde todos esos ordenadores iban a multiplicar sus usos y potencia más allá de lo inimaginable.

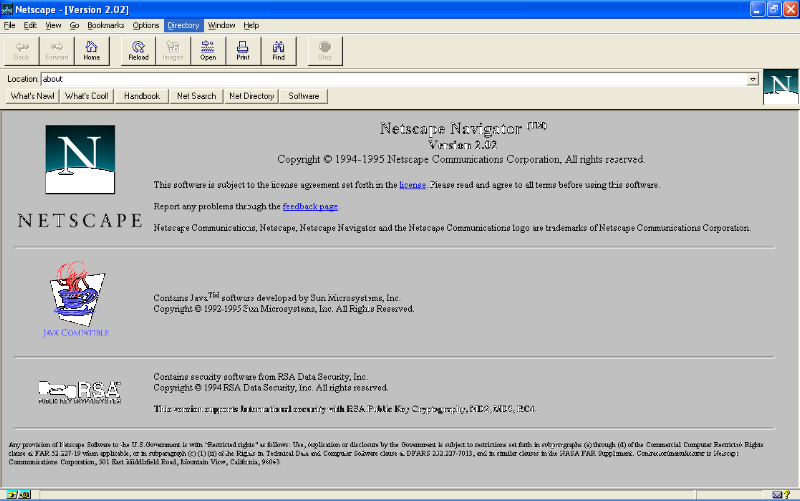

Netscape Navigator, uno de los primeros navegadores

El desembarco de la red global no hizo más que afianzar el modelo artístico de las ventanas y lo virtual, Internet abría una puerta a un nuevo mundo de posibilidades, explorar ese mundo era un proceso de probar una cosa tras otra, conectarte con más gente y mucho más… Incluyendo hasta una burbuja económica en 2001: la locura de las empresas “punto com”. Conforme Internet fue creciendo, se fueron creando una gran variedad de servicios, que mostraban un universo más allá de nuestro pequeño computador personal, la máquina se convertía en nuestro vehículo para alcanzar ese universo, llamado la World Wide Web o la gran red mundial que era Internet, dentro de este universo podríamos acceder y encontrar todo tipo de información o producto como si de un mundo real se tratara, así se vendió y desgraciadamente así se trato el campo económico lo que produjo un batacazo inversor descomunal siguiendo las reglas clásicas del capitalismo. Desde un punto de vista técnico Internet dio paso a protocolos como el FTP o File Transfer Protocol, un sistema con el que podríamos enviar cualquier tipo de archivo, igual que podríamos hacer en el mundo fuera de Internet, luego alcanzamos el protocolo SMTP (Simple Mail Transfer Protocol) y POP (Post Office Protocol), con ellos enviaríamos nuestros e-mails o correos electrónicos como si de una carta se tratará, solo que sería de una manera instantánea mejorando el modelo físico y abaratándolo, luego el IRC (Internet Relay Chat) el cual nos permitía mantener una conversación virtual con otra persona como si estuviéramos con ella, es decir, si el correo resultaba automático entonces era una charla (chat). Por otro lado nacía el protocolo NNTC (Network News Transport Protocol) el cual nos permitía acceder a los grupos de noticias como haríamos con la prensa escrita destrozando de paso el periodismo tradicional y llevándolo a una crisis permanente en la que actualmente nos encontramos, donde todavía no sabemos quién quedará vencedora si la veracidad y la calidad informativa o la futilidad de lo automático e inmediato sin valor alguno más allá del interés inmediato de los actores dominantes en liza.

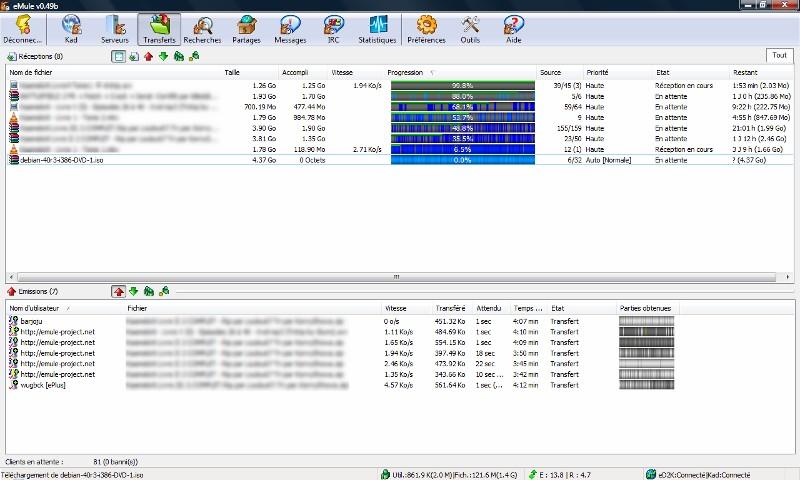

Emule uno de los primeros programas de intercambio de archivos P2P

Y por último no olvidar el protocolo P2P, el cual nos permitió compartir música, documentos, videos como podríamos hacer en el mundo real, sumiendo de nuevo a la industria musical en su eterna crisis victimista y propiciando un nuevo y polémico enfrentamiento / concepto social: la piratería digital vs libertad de compartir. El universo de Internet crecía cada día, mejoraba sus accesos, cada día era más fácil e intuitiva, más rápida, fluida y constantemente sorprendía al usuario con una mayor personalización, seguridad y eficiencia, provocando cada vez una dependencia mayor de este universo y cambiando nuestra visión del mundo real, dado el nuevo abanico de posibilidades que nos ofrecía este nuevo mundo virtual, el cual fue arrebatando cierto protagonismo al mundo real, en el mundo de la simulación y la virtualidad, ese universo detrás de una pantalla se fue imponiendo en muchos aspectos al mundo que conocíamos hasta ese momento gracias a la inmediatez y no a la inmersión como inicialmente se predijo.

Tim O'Reilly

A esta vuelta de tuerca en nuestra forma de vivir anteponiendo este mundo virtual sobre el real, en muchos aspectos se le conoció como la revolución de la Web o más conocido como la Web 2.0, como la bautizó T. O’Reilly en 2005, esta Web ya no se basaba en crear universos o simular situaciones, esta nueva Web nos permitía vivir de una forma literal en el mundo virtual y paralelo (al menos eso nos vendían), aunque probablemente acertó al mentirnos como veremos más adelante. La Web 2.0 perdiendo el control La famosa etiqueta de Web 2.0 permitía observar que esta revolución en el fondo solo era una mejora de la Web en manos de una industria en crecimiento que ya estaba aprendiendo a rentabilizar los servicios que ofrecía a sus clientes, desvinculándolos completamente de los conceptos asociados a la informática y el dominio de la máquina, ahora iba a ser la máquina quien dominara al ser humano con su beneplácito. El concepto de lo que se ha dado en denominar la Web 2.0 resulta algo difuso que se vende como “la Red creada por y para los usuarios”, pero realmente quiere decir que gran parte de la información y los contenidos que aparecen actualmente, son generados y distribuidos por los propios usuarios mediante artículos, videos, opiniones, comentarios en plataformas /empresas de terceros , sin que estos cobren retribución alguna por ello fomentado así, que el usuario asuma nuevos roles y responsabilidades de forma “gratuita” incitándole a que haga el trabajo, a cambio de los servicios y contenido, aunque este, pese a todo, considere que es el beneficiado y que el contenido realmente representa el sentir de los usuarios y no de las empresas e intereses que dan soporte a las plataformas donde ingresan sus contenidos. Dicho así suena un poco extremo, pero reconsiderémoslo y vayamos al principio: el término de Web 2.0 fue acuñado en 2004 durante un brainstorming durante la convención organizada por las compañías O'Reilly Media y Media Live International para analizar la evolución de Internet tras el estallido de la burbuja tecnológica de 2001.

En esta famosa reunión se definió la filosofía que tendría la nueva Web, como un conjunto de actitudes, tendencias y prácticas para operar en la Red (vino a ser según quien lo mire, la estrategia más inteligente o perversa en la historia de la comunicación):

Se planteo como una interface sencilla y rápida donde el protagonista tenía que ser el usuario, creando los contenidos por y para él, dándole ante todo la falsa sensación, (esto era muy importante y vital), de tener el control sobre cómo se creara y presentara la información, a través de mecanismos y filtros que no le hicieran sospechar que lo que creara (y además gratis) no estaba bajo su control. Los contenidos pues, debían poder ser creados también de forma colaborativa, fortaleciendo la idea de inteligencia colectiva, aumentando así su calidad y posibilidad de poder ser consumidos por un mayor número de usuarios con gustos afines. Era una premisa básica que gracias a la velocidad y potencia que había alcanzado la red, se debía satisfacer y beneficiar la experiencia del usuario por medio de un mayor grado de interacción que le provocara una absoluta satisfacción que deviniera en adicción, sería algo así como la fidelización a través de la interacción. Se propuso la Web como una plataforma de trabajo, para ello la gestión de las bases de datos seria una competencia básica y dominante de este nuevo concepto, las aplicaciones debían estar caracterizadas por la apariencia de simplicidad y una programación ligera, mientras que el software utilizado no debería estar limitado por las actualizaciones ni los dispositivos. El truco consistía en una evolución gradual del código que dejara inutilizables los antiguos dispositivos a medida se procedía a una continua actualización invisible de este código que ralentizaría los dispositivos más antiguos pero bajo la sensación errónea del usuario de que estos eran los culpables.

En cierta manera los equipos actuales realizan prácticamente las mismas funciones en red de hace diez años, pero para poder “mover” las aplicaciones más sencillas con fluidez como son las redes sociales o simples páginas como puede ser un periódico digital se necesitan cada vez equipos más potentes para poder ejecutar las ingentes cantidades de código y tráfico escondido que es el 90% de lo que “movemos”, como la publicidad y toda la información que se procesa y obtiene de nosotros.

Esto se consiguió superando las barreras tecnológicas con la aparición de los nuevos componentes: desarrollo del XML, tecnología Ajax, SOAP, uso extendido de las líneas ADSL y fibra óptica, aumento de aplicaciones construidas con código abierto...) Así la Red dejo de ser un simple escaparate de contenidos multimedia a la venta para convertirse en algo realmente interactivo, en una plataforma abierta construida sobre una arquitectura basada en el trabajo gratuito de los usuarios. La Web 3.0, ya no tienes ningún control (pero te venden que lo tienes más que nunca) En la era del concepto Web 2.0 aparecieron toda una serie de términos que parecían dar entidad al fenómeno de la nueva era de la comunicación: software social, contenidos de usuario, arquitectura de la participación, redes sociales, sindicación de contenidos, nubes de etiqueta y miles más que se nombraban alrededor de los nuevos paradigmas de esta realidad: comunidades y redes sociales, blogs y “wikis”. Esta nueva realidad estaba consiguiendo que sus usuarios se sintieran vinculados emocionalmente con los lugares a los que accedían, propiciando y alentando que se publicaran cantidades ingentes de contenidos para compartir con los demás. Con el tiempo los usuarios han ido comprendiendo que existían “filtros” y que ellos eran a la vez los creadores del “contenido” para un público determinado y el “producto”. Nadie niega ya la manipulación, el tráfico de nuestra información o la endogamia con la que las redes sociales vinculan a usuarios de intereses y gustos similares para ofrecerles productos interesantes para su comunidad o la inducción de ideas concretas afines a su pensamiento.

Todos son conscientes: empresas, gobiernos y usuarios, pero curiosamente se acepta el juego a cambio de los servicios y regresamos a una era primigenia donde el usuario comprende que existe una complejidad nueva e inabarcable que requiere de un profundo grado de conocimiento técnico en muchas materias para poder dominar la experiencia digital.

Como en todo existen grados de conocimiento y uso, de igual manera que al comienzo de la informática había quien usaba el ordenador solo para jugar un rato o escribir una carta, hasta quienes experimentaban con la conexión a redes telefónicas o intentaban conectar un robot industrial o centralizar la contabilidad, los recursos humanos y la gestión de stocks de su empresa. Todo son grados. Lo que podemos decir con claridad de la Web 3.0 es que ya forma un universo paralelo al nuestro, donde todo es posible: información veraz o falsa, aplicaciones que nos simplifican la vida o que de lo contrario, nos vampirizan, nos hacen adictos y nos roban el tiempo a cambio de nada, ocio inútil y ocio educativo que nos hace crecer intelectualmente, ocio sano y ocio que altera nuestra percepción de la realidad, las combinaciones son infinitas, sencillamente hemos pasado a vivir en simbiosis o dependencia (según el uso que le demos) con la informática e Internet. La única diferencia real con el siglo pasado radica en que no podemos obviar la necesidad de interactuar con ellos para ser miembros “normales” de esta nueva sociedad bajo el riesgo de acabar padeciendo un analfabetismo digital tan peligroso como pueda suponer ser controlado por ese nuevo universo de la información.

Autor: Roberto Vidal P.

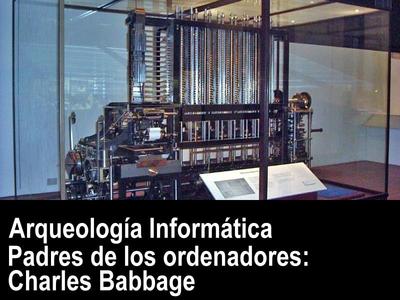

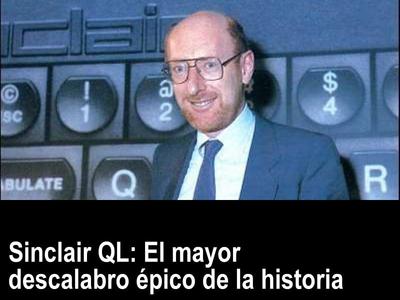

Temas relacionados: , Roberto Vidal P., Informática, Historia De La Tecnología, Mundo Retro, Retro Informática, Tecnología, Arqueología informática, Curiosidades de la tecnología Reconocimientos y más información sobre la obra gráfica ADVERTENCIA: En este foro, no se admitirán por ninguna razón el lenguaje soez y las descalificaciones de ningún tipo. Se valorará ante todo la buena educación y el rigor sobre el tema a tratar, así que nos enorgullece reconocer que rechazaremos cualquier comentario fuera de lugar.

0 Comentarios

Deja una respuesta. |